Объем данных растет стремительно: их собирают на сайтах, в приложениях, из соцсетей, касс и CRM, с датчиков и из других источников. Обычно сведения лежат в разных форматах и местах. Чтобы из этого хаоса сделать понятную картину, нужны правила хранения данных. Здесь помогают ETL-процессы.

Объясняем, как аналитики, дата-инженеры и руководители получают точные данные для отчетов, ML-моделей и решений. А еще рассказываем, где применяют ETL и как собрать процесс по шагам.

Что такое ETL

ETL — это процесс работы с данными, который состоит из трех шагов:

- Extract — извлечение;

- Transform — преобразование;

- Load — загрузка.

Если проще, цепочка выглядит так: достать — привести в порядок — положить туда, где удобно считать и анализировать. Для этого применяют коннекторы, очереди, проверки качества, расписания и контроль версий.

ETL-процессы должны работать как конвейер, который каждый день делает одно и то же: забирает данные из источников, чистит их по понятным правилам и складывает в витрины или хранилище. Тогда BI-дашборды обновляются автоматически, а аналитик видит единую картину.

Кто и где использует ETL

Процессы нужны там, где больше одного источника данных.

- Ритейл. Кассы, интернет-магазин, программа лояльности, склад — разные системы. ETL собирает данные о продажах, остатках, чеках, акциях в одну модель, где видны показатели всей сети и каждого магазина.

- Маркетинг. Сведения хранятся в рекламных кабинетах, веб-аналитике, CRM. ETL объединяет клики, показы, заявки, затраты в один дашборд, а вы считаете стоимость привлечения клиента (САС), окупаемость вложений (ROMI) и другие метрики по кампаниям без дублей.

- Производство и интернет вещей. Источники информации: датчики, *SCADA, **MES. ETL сглаживает рывки телеметрии, переводит единицы измерения, синхронизирует время и формирует витрины для контроля брака и простоев.

- Финансы. Бухгалтерия и казначейство могут иметь отдельные базы. ETL приводит план-факт, сверяет данные, собирает ликвидность и долговую нагрузку в одном окне.

- Образование и EdTech. ***LMS, ****прокторинг, платежи. ETL объединяет активность студентов, оплаты и результаты в единую картину прогресса.

*SCADA (Supervisory Control and Data Acquisition) — программа для диспетчерского управления и сбора данных с датчиков.

**MES (Manufacturing Execution System) — программа, которая отслеживает все производственные операции: от закупки сырья до контроля партий продукта.

***LMS (Learning Management System) — система управления обучением, в которой фиксируется весь процесс: от изменений в учебных программах до успеваемости студентов.

****Прокторинг — система, в которой отслеживается прохождение онлайн-экзаменов и тестов.

Как работает ETL-процесс: 3 этапа

Извлечение (Extract)

Задача — аккуратно забрать данные из баз данных, API, файлов, очередей событий и других источников.

Как это сделать:

- Подключиться к источнику с помощью коннектора. Для PostgreSQL, MySQL, Oracle есть драйверы, для рекламных кабинетов — API. Для файлов применяют FTP и облачные программы.

- Выбрать режим. Возможна полная выгрузка или инкременты — по фильтрам времени, CDC-логам и другим параметрам. Последний вариант экономит время и ресурсы.

- Продумать защиту. Например, таймауты, *ретраи, **backoff. Ограничения помогают избежать сбоев в системе.

*Ретрай (retry) — логика повторного выполнения операции, если она прошла неудачно.

**Backoff — задержка при повторной попытке выполнения операции.

Преобразование (Transform)

Задача — превратить сырые таблицы в чистые и совместимые слои, которые будут дополнять друг друга.

Этапы преобразования:

- Чистка. Нужно убрать лишние строки, унифицировать форматы дат и валют, привести справочники к единому виду.

- Бизнес-правила. Это логика перевода данных в единую систему. Нужно определить метрики и сущности, например «Покупатель», «Заказ», «Кампания». А еще — продумать, что будет считаться дублями и как их исключать.

- Контроль качества. Проводят тесты на свежесть (freshness), полноту (volume), уникальность ключей, допустимые диапазоны.

- Документация. Здесь важно описать модели, источники, зависимости. Это нужно, чтобы новые сотрудники могли быстро включиться в работу.

Загрузка (Load)

Задача — поместить очищенные данные туда, где их удобно читать. Это могут быть корпоративные хранилища (DWH), витрины данных и другие источники.

Варианты:

- классические хранилища — PostgreSQL, Greenplum, Vertica, Teradata;

- массово-параллельная архитектура (MPP) и облачные решения — BigQuery, Snowflake, Redshift, ClickHouse;

- репозитории Data Lake — S3 или MinIO.

В чем преимущества ETL-процессов

Собирать, чистить и хранить данные в одном месте полезно по нескольким причинам:

- единый вид — все сотрудники интерпретируют метрики одинаково, не возникает разночтений;

- повторяемость — процесс можно запускать по расписанию, без ручных правок;

- масштабируемость — источники можно добавлять, не меняя всю схему;

- управление качеством — тесты и мониторинг данных ловят проблемы до того, как с ними столкнутся пользователи.

Однако ETL — это недешево. Нужны квалифицированные сотрудники, продуманная инфраструктура и постоянный контроль качества. Важно поддерживать инженерную дисциплину: создавать код-ревью, сверять версии, проводить тесты.

ETL-инструменты

Есть готовые решения, которые можно синхронизировать с источниками данных. Главное — проверить совместимости и функционал.

Платные ETL-системы

Informatica, Talend Data Fabric, IBM DataStage — решения с богатыми каталогами коннекторов, управлением метаданными и поддержкой SLA.

Fivetran, Stitch, Airbyte Cloud — быстро подтягивают коннекторы к сотням источников, работают с инкрементами. Минус — ограниченная гибкость.

Matillion, Hevo, Estuary — удобные конструкторы пайплайнов под облачные DWH.

Бесплатные и open-source ETL

Apache Airflow — оркестратор задач. Программа управляет зависимостями и расписаниями.

Data Build Tool (DBT) — декларативные SQL-модели и тесты. Они версионируются как код, встают поверх современных DWH.

Airbyte — коннекторы на CDK. Программа с открытым кодом, поэтому легко дописать свой инструмент.

ETL в облаке

Варианты:

- BigQuery, Dataform, Cloud Composer (Airflow) — набор инструментов от Google;

- Snowflake, Snowpipe, Snowpark — комплекс Snowflake, который применяют в совокупности;

- решения от Azure.

В облаке проще масштабировать хранение и вычисления, настраивать роли и аудит, быстрее подключать внешние источники. Это снижает порог входа для команд, которым важна скорость запуска без большого штата админов.

Как реализовать ETL-процесс

Шаг 1. Сформулируйте бизнес-цели. Важно выделить приоритетные направления и поставить задачи конкретно. Пример: «Собрать дашборд, который каждый день к 8:00 будет показывать актуальную валовую прибыль по категориям и каналам с разбивкой по промо». Так будет понятно, какие базы данных подключать и какие инструменты понадобятся.

Шаг 2. Опишите источники. Добавьте схемы, поля, ключи, ограничения, таймзоны, лимиты API. Зафиксируйте все необходимые ресурсы и настройки в репозитории.

Шаг 3. Спроектируйте целевую модель. В частности, определитесь, какие будут слои данных:

- staging — сырые и близкие к источнику;

- core — нормализованные;

- marts — адаптированные под BI или продукт.

Шаг 4. Выберите стек для анализа. Минимальный набор: оркестратор (Airflow или Prefect), слой трансформаций (DBT, SQL или Spark), хранилище (BigQuery, Snowflake, ClickHouse или Postgres), система контроля качества (Great Expectations).

Шаг 5. Реализуйте извлечение. Начните с одного параметра, настройте инкременты. Сразу добавьте логирование и метрики.

Шаг 6. Напишите трансформации. Делайте маленькие, проверяемые шаги. Каждую модель протестируйте на уникальность и вывод not null.

Шаг 7. Настройте загрузку и права. Определите, куда будут попадать данные и каким образом. Ограничьте доступ к сырым данным, назначьте уровни доступа для сотрудников.

Шаг 8. Включите мониторинг. Отслеживайте процент успешных операций, длительность сессий, объем обработанных данных. Фиксируете аномалии и отлаживайте их.

Шаг 9. Задокументируйте ETL-процессы. Настраивайте автогенерацию описаний в DBT, добавляйте ручные пояснения по метрикам.

Шаг 10. Составьте план улучшений. После запуска оцените узкие места. Например, может понадобиться заменить медленные сервисы, добавить дополнительные правила очистки данных.

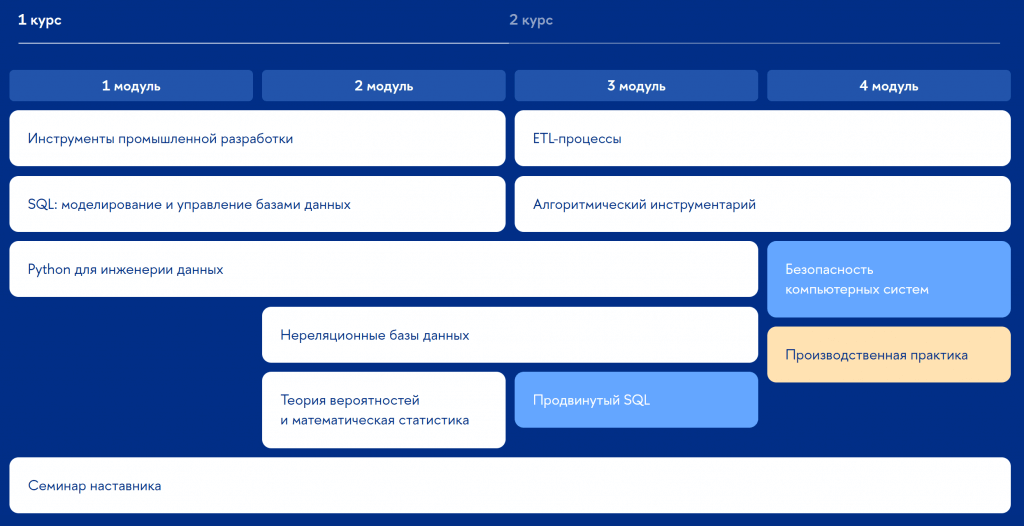

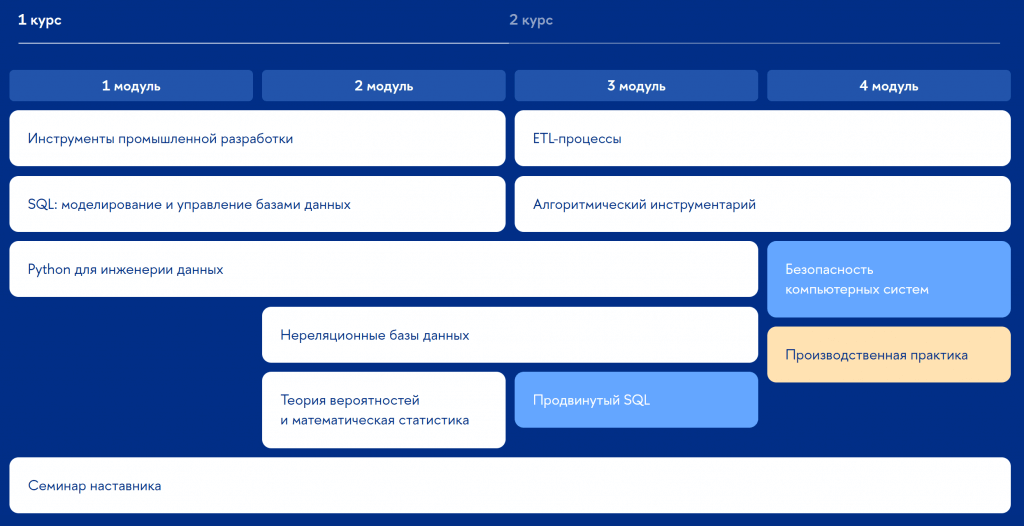

Чтобы реализовать ELT-процесс, нужно уметь сопоставлять данные, настраивать алгоритмы работы, владеть языками программирования и структурированных запросов. Все эти компетенции можно освоить в онлайн-кампусе НИУ ВШЭ. Вы будете практиковаться на реальных проектах и консультироваться с лидерами рынка в рамках системы наставничества. Например, на магистерской программе «Инженерия данных» учат строить ETL-процессы, работать с SQL, базами данных и собирать программные стеки для анализа.

Учебный план магистерской программы «Инженерия данных»

Примеры ETL-систем

Пример 1. Ритейл-сеть среднего размера.

Источники. POS-чек, 1С, e-commerce, CRM, программа лояльности.

Стек. Airbyte для коннекторов, Airflow для расписаний, ClickHouse как DWH, DBT для модельного слоя.

Результат. Команда видит витрины продаж с ежедневным обновлением к 7:30, ABC/XYZ-классификацию покупательских сегментов, результаты промо-анализа.

Пример 2. Маркетинг-аналитика в сервисе подписки.

Источники. AppsFlyer, Google Ads, веб-аналитика, платежный провайдер.

Стек. Fivetran для извлечения, BigQuery как DWH, DBT для трансформаций, Looker Studio для отчетов.

Результат. Построена единая воронка: показы → клики → регистрации → платежи. Автоматически производится расчет LTV по когортам и ROMI по кампаниям с задержкой в 1 день.

Как построить ETL-процессы

Чек-лист на старте:

- Сформулируйте бизнес-метрики и правила готовности данных.

- Опишите источники и выберите инкрементальный способ извлечения.

- Спроектируйте слои: staging → core → marts. Сразу решите, где и как будут работать бизнес-правила.

- Сформируйте программный стек: оркестратор, хранилище, слои трансформаций, система контроля качества.

- Введите тесты данных, проверьте их полноту и уникальность.

- Настройте доступы. Пользователям можно показывать витрины и дашборды с обработанной информацией, сырые данные пусть видят только инженеры.

- Задокументируйте модели и метрики, сохраните код в Git.

- Запланируйте поддержку: ретраи, регламенты на случай сбоев